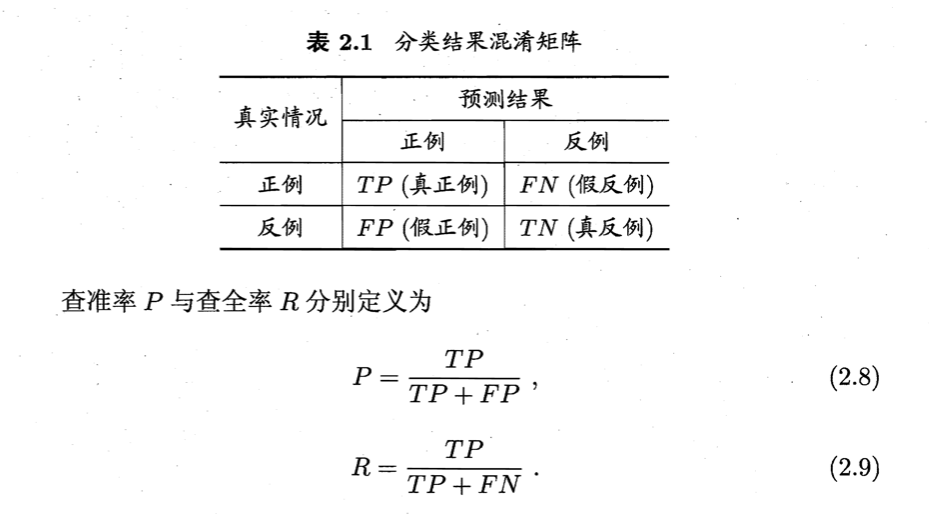

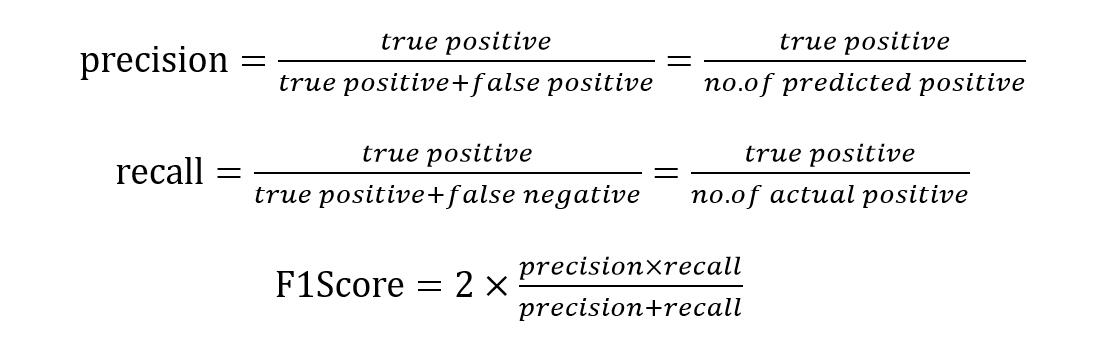

准确率和召回率

$F1=(2PR)/(P+R)$

ROC 和 AUC

很多学习器是为测试样本产生一个实值或概率预测,然后将这个预测值与分类阈值进行比较,如果大于阈值为正例,反之为负例。根据这个预测值(概率预测结果),可以将测试样本进行排序,最可能是正例的排在最前面,最不可能是正例的排在最后面。

在不同应用中,可根据任务需求采用不同截断点,如果更重视准确率,可选择排序中靠前的位置进行截断,如果更重视召回率,可选择靠后的位置进行截断。

ROC受试者工作特征(Receiver Operating Characteristic)曲线,与 P-R曲线使用准确率和召回率为纵、横坐标不同,ROC 曲线的纵轴是真正例率(True Positive Rate,TPR),横轴是假正例率(False Positive Rate,FPR)。

$TPR = \cfrac{TP} {TP + FN}$

$FPR = \cfrac{FP} {FP + TN}$

ROC 曲线绘制过程:给定 m 个正例和 n 个反例,根据学习器预测结果对样例进行排序,然后把分类阈值设为最大,即把所有样例均预测为反例,此时 TPR 和 FPR 都是 0,在坐标(0,0)处标记一个点,然后将分类阈值依次设为每个样例的预测值,即依次将每个样例划分为正例。设前一个标记点坐标是(x,y),当前如果是正例,则对应标记点的坐标为(x, y + 1/m); 当前如果是假正例,对应标记点为(x + 1/n,y),然后用线段连接相邻点即可。

AUC(Area Under ROC Curve)可通过对 ROC 曲线下各部分的面积求和而得。

准确率(accuracy) = 预测对的/所有 = (TP+TN)/(TP+FN+FP+TN)

精确率(precision) = TP/(TP+FP)

召回率(recall) = TP/(TP+FN)

参考资料

- 《机器学习》周志华